- -

- 100%

- +

Merksatz

Wissenschaftliche Formen der Selbst- und Fremdbeobachtung sind theoriegeleitet, systematisiert und den allgemeinen Gütekriterien der Datenerhebung unterworfen.

Die teilnehmende Beobachtung ist ein Verfahren, bei dem die forschende Person selbst am untersuchten Geschehen teilnimmt und von den erforschten Personengruppen wie ihresgleichen behandelt werden möchte. Man erwartet sich dadurch sowohl eine lebensnähere Perspektive des beforschten Phänomens als auch tiefere Einblicke in die jeweilige Problematik. Bei nichtteilnehmender Beobachtung ist man als Forscher den Untersuchungspersonen gegenüber distanzierter eingestellt und an objektiven Ergebnissen interessiert. Verdeckte Beobachtungen haben den Vorteil, dass der beobachtete Prozess natürlich und ungestört ablaufen kann, aber unter Umständen ist mit Unmut (z.B. bei Täuschungen) und Verweigerung der Zustimmung zur Datennutzung zu rechnen (gemäß „Ethikrichtlinien“ der Psychologie ist eine Einverständniserklärung durch die Betroffenen erforderlich). Offene Beobachtungen haben häufig den Nachteil, dass sich die Beobachteten imageorientiert, skeptisch, übertrieben oder sonst irgendwie unnatürlich verhalten. In einer frühen Forschungsphase, wenn noch keine konkreten Vorstellungen über gesetzmäßige Zusammenhänge im Forschungsfeld vorhanden sind, werden unstrukturierte Beobachtungen überwiegen, während bei zunehmender Klarheit über die zu erwartenden Gesetzmäßigkeiten immer mehr zu strukturierten Beobachtungen übergegangen werden kann. Dies bedeutet dann, dass Schemata und Eintragslisten entwickelt werden, anhand derer Beobachterinnen und Beobachter ihre Wahrnehmungen steuern und kategorisieren können.

Befragung (Interview)| 3.7.6Da die verschiedenen Varianten der Befragung zu den häufigsten Methoden der Datengewinnung in den Sozialwissenschaften zählen, werden sie auch manchmal als deren „Königsweg“ bezeichnet (Ebster & Stalzer, 2003). „Befragung bedeutet Kommunikation zwischen zwei oder mehreren Personen. Durch verbale Stimuli (Fragen) werden verbale Reaktionen (Antworten) hervorgerufen: Dies geschieht in bestimmten Situationen und wird geprägt durch gegenseitige Erwartungen.“ (Atteslander, 2003, 120)

Merksatz

Die Befragung ist ein sehr häufig eingesetztes sozialwissenschaftliches Verfahren der Datenerhebung, welches in strukturierter Form auch einer statistischen Auswertung zugeführt werden kann.

Texttranskription: Exakte schriftliche Protokollierung mündlicher Äußerungen

Ein wichtiges Unterscheidungsmerkmal von Befragungen ist der Grad ihrer Standardisierung. Hinsichtlich der Freiheitsgrade bei der Durchführung von Gesprächen mit Untersuchungspersonen unterscheidet man standardisierte, teilstandardisierte - und nichtstandardisierte Befragungen (Interviews). Nichtstandardisierte Interviews (mit wissenschaftlicher Basis) werden auch als „qualitative Befragungsmethoden“ zusammengefasst. Dazu zählen etwa das Intensiv- oder Tiefeninterview, das Gruppeninterview, das narrative Interview - und die qualitative Inhaltsanalyse (Flick et al., 1995). Da bei diesen Befragungen nur wenige Einschränkungen für den Ablauf des Interviews gegeben sind (z.B. hinsichtlich der Thematik), laufen die Gespräche relativ ungezwungen und spontan ab, und es kommen viele Inhalte und Gedanken zur Sprache, die sonst kaum genannt worden wären. Allerdings erfordert diese Art von Datenerhebung beträchtliche kommunikative Fertigkeiten bei den interviewführenden Personen bzw. entsprechende Schulungen, da natürlich der Output des Interviews sowohl vom Inhalt als auch vom Umfang her durch das (auch nonverbale) Verhalten des Interviewers verfälscht werden kann (z.B. in Richtung eigener theoretischer Annahmen).

Anamnese: Vorgeschichten einer seelischen oder körperlichen Erkrankung

Bei standardisierten (strukturierten) Befragungen hingegen sind die Formulierungen der Fragen fix vorgegeben, sodass alle Befragungspersonen zu den gleichen Inhalten Stellung nehmen müssen. Die Beantwortungen der Fragen können im offenen Antwortmodus erfolgen, das heißt mit eigenen Worten. Dies bedeutet zwar einerseits (wie bei den qualitativen Befragungsmethoden) eine Chance auf mehr Information, ist aber andererseits mit größerem Auswertungsaufwand (z.B. Texttranskription) und erschwerter Vergleichbarkeit der Aussagen verbunden. Bei einem geschlossenen Antwortmodus sind für die einzelnen Fragen auch deren Antwortmöglichkeiten vorgegeben und die befragten Personen müssen sich für eine oder mehrere davon entscheiden („multiple choice“). In diesem Fall ist die Objektivität der Ergebnisse fast immer höher, aber der unmittelbare Lebensbezug und die Spontaneität der Meinungswiedergabe reduziert. Ein wesentlicher Vorteil des geschlossenen Antwortmodus in Fragebögen ist allerdings auch seine bessere Verwertbarkeit für statistische Analysen, sodass sich in den letzten Jahrzehnten diese Form in vielen Bereichen der Sozialforschung durchgesetzt hat.

3.7.7 |TextanalyseIn keiner Wissenschaft kann auf die Bedeutungsanalyse sprachlicher Aussagen verzichtet werden. Besonders trifft dies auf die Psychologie zu, wenn es um die Beschreibung spontaner Beobachtungen geht, wenn Schilderungen von Erlebnissen ausgewertet werden sollen, wenn schriftliches Material über Nachrichten oder Gespräche vorliegt (Mitschriften, Protokolle, Tagebücher, Archive, Zeitungsberichte etc.) oder wenn zur Diagnose von Störungen Anamnesen angefertigt werden.

Merksatz

Textanalysen bezwecken eine abstrakte und komprimierte Beschreibung des Aussagegehalts alltagssprachlicher Texte.

Daten dieser Art können – wie aus der Kommunikationsforschung bekannt ist – sehr unterschiedlich interpretiert werden, sodass für die Bedeutungsanalyse unstrukturierter Texte Auswertungsmethoden entwickelt wurden, die auch die oben genannten Gütekriterien der Datengewinnung erfüllen sollten. Diesem Anspruch entsprechen insbesondere die qualitative - und die quantitative Inhaltsanalyse, mittels derer der Bedeutungsgehalt von umfangreichen Textteilen in Form von prägnanten Aussagen („Propositionen“) zusammengefasst oder aber eine Auszählung der am häufigsten vorkommenden Begriffe und Begriffs kombinationen in den Textdaten vorgenommen werden kann. Diese quantitative Inhaltsanalyse wurde bereits in den Dreißigerjahren zur Analyse von Massenmedien verwendet, etwa um die politische Orientierung in einem Land durch die Frequenz positiver oder negativer Charakterisierungen von Themen in Tageszeitungen zu belegen.

Für die Inhaltsanalyse von gespeicherten Texten stehen Computerprogramme zur Verfügung, die z. T. kostenlos als Demoversionen aus dem Internet zu beziehen sind (z.B. www.atlasti.de, www.winmax.de).

Die qualitative Inhaltsanalyse (s. Mayring, 2000) knüpft an diesen Ansatz an und versucht durch Einführung verbindlicher methodischer Regeln bei der Textanalyse deren Objektivität, Reliabilität und Validität zu verbessern. Dabei wird der Aussagegehalt von Sätzen oder Absätzen eines Textes mit Begriffen versehen, die entweder schrittweise aus dem Textmaterial herausentwickelt („induktive Kategorienentwicklung“) oder aufgrund theoretischer Überlegungen und Auswertungsinteressen sukzessive an die Textinhalte angepasst werden („deduktive Kategorienanwendung“). Das Ergebnis solcher Analysen ist eine oberbegriffliche, abstrakte Darstellung des Aussagegehalts von Textmengen durch Begriffe, Begriffskombinationen oder einfache Aussagen („Propositionen“), welche bei Bedarf auch noch einer statistischen Auswertung (z.B. einer Häufigkeitsauszählung mit Computer) unterzogen werden können.

Simulationsstudie (Computersimulationen)| 3.7.8Ein moderner wissenschaftlicher Ansatz für die Analyse komplexer Systeme ist die Systemtheorie (Bossel, 1992; Bischof, 2016), „eine interdisziplinäre Wissenschaft, deren Gegenstand die formale Beschreibung und Erklärung der strukturellen und funktionalen Eigenschaften von natürlichen, sozialen oder technischen Systemen ist“ (Bibliogr. Institut & Brockhaus, 2002). Ihr theoretisches Gerüst wurde bereits in verschiedenen Bereichen erfolgreich erprobt und angewendet (z.B. in Politik, Biologie, Ökonomie, Technik, Verkehrsplanung, Flugverkehrsleitung, Epidemiologie). Auf der Grundlage systemanalytisch konstruierter Modelle wurden Computersimulationen auch für komplexe Anwendungsbereiche erstellt, etwa: „Waldwachstum“, „Mondlandung“, „Ressourcennutzung“, „Tourismus und Umwelt“, „Lagerhaltung“, ökologische Simulationsspiele wie „Ökolopoly“, „Ökopolicy“ (Vester, 1997), Entwicklungsmodelle für Länder (Bossel, Hornung & Müller-Reißmann, 1989) oder „Weltmodelle“ (Meadows, Meadows & Randers, 1992).

Frühe Simulationsmodelle der Psychologie stammten aus dem Forschungsgebiet Denken und Problemlösen (Kap. 8) und dienten dazu, komplexe Problemsituationen des Alltags auch in Laborsituationen zu untersuchen. Putz-Osterloh und Lüer (1981) entwickelten eine Computersimulation eines Schneiderladens („Taylorshop“), anhand derer Versuchspersonen über die betriebswirtschaftliche Situation einer fiktiven Firma informiert wurden und in verschiedenen Durchgängen nach eigenem Ermessen betriebliche Maßnahmen setzen konnten. Ein wesentlich komplexeres Beispiel ist ein programmiertes Bürgermeisterspiel, in dem eine fiktive Kleinstadt namens „Lohhausen“ von Versuchspersonen mit weitgehenden (diktatorischen) Vollmachten nach gewissen Zielkriterien (z.B. Wirtschaftsdaten, Bevölkerungszufriedenheit, Umweltsituation) zu regieren war (s. 8.2). Ein jüngeres Projekt des „Institutes für theoretische Psychologie“ der Universität Bamberg ist „PSI“, eine Computersimulation einer „beseelten Dampfmaschine“, die „ihr schweres Leben“ auf einer Insel in einer „labyrinthartigen Landschaft“ nach menschlicher Logik fristet (Dörner & Schaub, 2006).

Die Übersetzung einer Theorie in ein Computerprogramm bedeutet eine präzise Prüfung der Widerspruchsfreiheit, Vollständigkeit und Nachvollziehbarkeit ihrer Annahmen (Box 3.5). Die simulierten Entscheidungen eines Computermodells menschlicher Informationsverarbeitung können mit jenen von Versuchspersonen in gleichen Situationen verglichen werden, um die zugrunde liegende Theorie zu verbessern (Dörner & Gerdes, 2003).

Merksatz

Simulationsstudien in der Psychologie bezwecken eine formale, systemanalytische und kybernetische Beschreibung von Mensch- und Umweltsystemen.

Computerprogramme und Simulationsmodelle, die für kognitionspsychologische Forschungszwecke eingesetzt werden, sind über das Internet kostenlos zu beziehen (z.B. ACT-R: „Adaptive Control of Thought“; COGENT: „Cognitive Objects within a Graphical EnviroNmenT“; SOAR: „States Operators And Results“; PSI: eine psychologische Theorie als Computerprogramm). Das allgemeine Ziel solcher Programme und Konzepte darf darin gesehen werden, für kognitive und mentale Prozesse eine vereinheitlichende psychologische Theorie zu entwickeln.

Entwicklungsschritte für Simulationsmodelle | Box 3.5

Bei der Entwicklung eines Simulationsmodells für ein empirisches System gelten im Wesentlichen folgende Schritte:

1. Das System im Detail verbal beschreiben („Wortmodell“)

2. Für das System die Systemgrenzen bestimmen (zur Umwelt oder anderen Systemen)

3. Wichtige Untersysteme (Module) und ihre Wirkungsbeziehungen identifizieren

4. Die Wirkungsdynamik des Modells spezifizieren (Systemelemente und Beziehungen zwischen den Elementen und Variablen des Systems festlegen, Zustandsgrößen definieren, Rückkoppelungen erfassen, exogene Einflüsse bestimmen etc.)

5. Die Systemstruktur und die Systemdynamik in ein formales Modell übertragen (Erstellung des Computerprogramms)

6. Strukturgültigkeit des Modells überprüfen (z.B. den Grad der Übereinstimmung seiner Elemente und Elementrelationen mit jenen des empirischen Systems)

7. Verhaltensgültigkeit prüfen (die Modelldynamik soll robust sein und plausible Verläufe bei den Outputvariablen zeigen)

8. Empirische Modellgültigkeit testen (Zeitreihen des Modells werden mit solchen des abgebildeten Systems verglichen, Eingaben von bekannten, realistischen Szenarien müssen erwartete Ergebnisse liefern)

(In Anlehnung an Bossel, 1992)

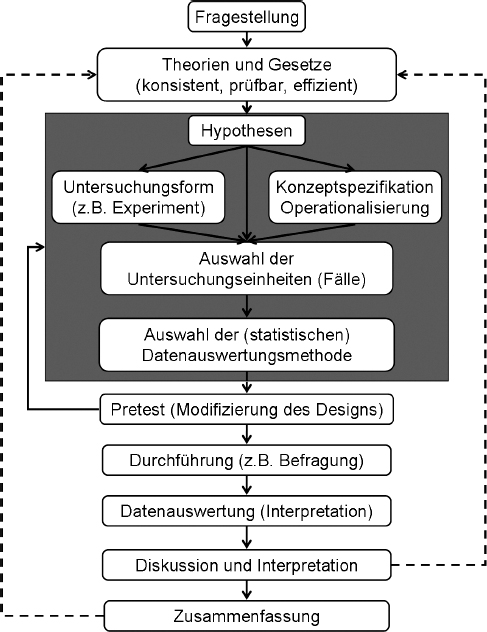

3.8 |ForschungsablaufHinsichtlich der Entwicklung eines Forschungsprojekts werden grob drei Phasen unterschieden (Friedrichs, 1990; Atteslander, 2003):

(1) Die Phase des „Entdeckungszusammenhangs“ kennzeichnet, in welcher Weise der Zugang zur Thematik gefunden wurde und welche Gründe für das Aufgreifen der Fragestellung maßgeblich waren.

(2) In der Phase des „Begründungszusammenhanges“ sollen die in der Fragestellung angesprochenen Gesetzmäßigkeiten einer empirischen Untermauerung zugeführt werden. Dabei geht man von bereits bewährten psychologischen Theorien - und Gesetzmäßigkeiten aus, um für die Fragestellung ein solides theoretisches Konzept zu entwerfen, welches widerspruchsfrei (konsistent), empirisch prüfbar (verifizierbar- oder falsifizierbar) und sparsam in der Erklärung (effizient) zu sein hat. Aufgrund fachwissenschaftlicher Erfahrungswerte über die Zweckentsprechung spezieller wissenschaftlicher Forschungsansätze und Forschungsmethoden wird sodann für die Fragestellung ein Forschungsdesign entworfen, welches die Hypothesenformulierung, die Wahl der Untersuchungsmethode, die Ausarbeitung der Operationalisierungen - und die Stichprobenselektion inkludiert. Nachdem das Forschungsdesign in Voruntersuchungen auf seine Eignung getestet wurde, kommt es zur Durchführung der Untersuchung und zur (meist statistischen) Auswertung der gewonnenen Daten, wobei insbesondere auf Verteilung - und Skalenqualität der Variablen zu achten ist. Nach der Interpretation der Auswertungsergebnisse sowie nach deren theoriebezogener Diskussion (z.B. über Widersprüche zu Annahmen, Verallgemeinerbarkeit der Ergebnisse, Gefahr von Artefakten) werden die wichtigsten Schlussfolgerungen aus der Untersuchung in theoretisch-abstrakter Form zusammengefasst.

(3) Die Phase des „Verwertungs- oder Wirkungszusammenhangs“ schließlich bezieht sich auf die verschiedenartigen Nutzungsmöglichkeiten der Forschungsergebnisse, wie etwa auf deren Beitrag zur Verbesserung theoretischer Positionen, deren Verbreitung über Publikationen und Vorträge sowie deren Umsetzung im gesellschaftlichen Bereich.

| Abb 3.11

Der Forschungsablauf empirischer Untersuchungen lässt sich in verschiedene Stadien gliedern: Den Ausgangspunkt liefert die Fragestellung, die theoretisch oder praktisch begründet sein kann. Für die ausgewählte Thematik wird der bisherige wissenschaftliche Erkenntnisstand festgestellt und eine theoretische Basis in Form relevanter psychologischer Gesetze oder Theorien gesucht. Danach wird ein Forschungsdesign entworfen (dunkles Feld), indem für die theoretisch untermauerte Fragestellung empirisch überprüfbare Hypothesen, eine geeignete Untersuchungsform, konzeptspezifische Operationalisierungen, eine sinnvolle Fallstichprobe sowie eine datenadäquate Datenauswertungsmethode gefunden werden. In einem Vortest wird das Forschungsdesign auf Tauglichkeit überprüft und danach zumeist einer Revision unterzogen. Nun erst erfolgen die Durchführung der Untersuchung, die Datensammlung, die Datenauswertung, die Diskussion und die Interpretation der Ergebnisse. Den Abschluss bildet die zusammenfassende Präsentation der Forschungsresultate in einer prägnanten und theoriebezogenen Form.

Was die wissenschaftliche Qualität von Veröffentlichungen betrifft, so ergeben sich die Kriterien dafür zunächst aus den bisher beschriebenen formalen und inhaltlichen Anforderungen des Forschungsablaufs. In den letzten Jahrzehnten orientiert man sich bei der Bewertung von Publikationen – wie übrigens in den Naturwissenschaften auch – am fachlichen Image des Publikationsorgans. Besonders hoch bewertet werden dabei solche Zeitschriften, deren Artikel in der Fachwelt (scientific community) stark beachtet, d.h. häufig zitiert werden. Diese Betonung des Wahrheitskriteriums Konsensus drückt sich im sogenannten Impact Factor einer Zeitschrift aus. Dieser gibt an, wie oft die Artikel einer bestimmten Zeitschrift der letzten beiden Jahrgänge im nachfolgenden Jahr in anderen Zeitschriften zitiert werden. Für eine solche statistische Analyse bedient man sich spezifischer Datenbanken, in denen nicht nur die Titel und die Autorenschaften von periodischen Veröffentlichungen gespeichert sind, sondern auch die in ihnen vorkommenden Verweise auf andere Publikationen („Social Sciences Citation Index“ – SCI; „Science Citation Index“ – SSI; „Web of Science“). Wenn Veröffentlichungen in Zeitschriften mit hohem Impact Factor erscheinen, haben sie eine größere Chance, zitiert zu werden und bei wissenschaftlichen Leistungsbeurteilungen zu punkten. Jene psychologischen Zeitschriften mit dem höchsten Impact Factor sind „Annual Review of Psychology“, „Psychological Bulletin“, „Psychological Methods“.

Zusammenfassung

Die wissenschaftliche Beschreibung und Erklärung menschlicher Erlebnisse, Bewusstseinsabläufe und Verhaltensweisen kann ganz allgemein als Versuch der Abbildung eines empirischen, konkreten Systems in ein theoretisches, abstraktes System verstanden werden. Die Überbrückungsfunktion leistet ein Korrespondenzsystem (Forschungsmethoden), mittels dessen ein Bezug zwischen den empirischen Tatsachen und den sie erklärenden psychologischen Gesetzen und Theorien hergestellt wird.

Ebenso wie in anderen empirischen Wissenschaften werden auch in der Psychologie Gesetzmäßigkeiten vorerst an Stichproben gewonnen und überprüft, um sie danach für die Grundgesamtheit von Sachverhalten (Population) verallgemeinern zu können. Gesetze werden statistisch als Relationen zwischen unabhängigen und abhängigen Variabeln formuliert, wobei diese Relationen oft durch Moderatorvariablen beeinflusst und durch Störvariablen verfälscht sind. Die vielfältigen Vernetzungen von Wirkungsbeziehungen im psychologischen Forschungsbereich können durch direkte oder durch indirekte Kausalbeziehungen erklärt werden, die beobachteten Effekte lassen sich zumeist auf mehrere Ursachen (Multikausalität) und/oder auf bedingt wirksame Ursachen zurückführen. Aufgrund der vielfältigen Effekt- und Fehlerüberlagerungen hat man es in der Regel mit multivariaten Wahrscheinlichkeitsgesetzen zu tun.

Die Deskriptivstatistik liefert statistische Kennwerte für die Verteilung von Variablenausprägungen und transformiert Variablen – zur besseren Vergleichbarkeit – in Standardvariablen mit gleichem Mittelwert und gleicher Streuung. Die statistischen Relationen zwischen Variablen können, in Abhängigkeit von ihrer quantitativen Interpretierbarkeit, mithilfe von Vektoren als grafische Darstellungen von Korrelationsbeziehungen charakterisiert werden. Bei Bedarf lassen sich komplexe Variablensysteme, etwa mittels Faktorenanalyse, auch in einfachere Strukturen überführen.

Um festzustellen, ob die anhand einer Stichprobe gewonnenen Variablenrelationen als Gesetze verallgemeinert werden können, benötigt man die Inferenzstatistik, welche unter Heranziehung von Wahrscheinlichkeits- oder Zufallsmodellen die statistische Signifikanz (Bedeutsamkeit) von Untersuchungsergebnissen feststellt. Die Inferenzstatistik wird also dafür eingesetzt, den Grad der allgemeinen Gültigkeit von Hypothesen anhand von Stichproben zu prüfen.

Die wichtigsten Forschungsmethoden sind das Experiment, das Quasiexperiment, die Feldforschung, Testverfahren, Ratings, die Beobachtung, die Befragung, die Textanalyse und die Computersimulation. Allen Datenerhebungsinstrumenten der Psychologie ist gemeinsam, dass sie wissenschaftlichen Gütekriterien genügen müssen (Objektivität, Reliabilität, Validität usw.).

Ein typisches Forschungsprojekt beginnt mit einer Fragestellung, für die thematisch angrenzende Theorien und Erklärungsansätze aus der Fachliteratur zu recherchieren sind. Für die Fragestellung wird jenes Forschungsdesign ausgewählt, das am ehesten eine empirische Evaluation der Fragestellung erlaubt. Vor- und Hauptuntersuchungen werden durchgeführt, die Daten statistisch ausgewertet, die Ergebnisse interpretiert, analysiert, diskutiert und schließlich in ihrer theoretischen und praktischen Bedeutung zusammenfassend dargestellt.

Fragen

1. Welche allgemeinen Kriterien für Wissenschaftlichkeit werden von Wissenschaftstheoretikerinnen und -theoretikern vorgeschlagen?

2. Welche Schritte und Konzepte kennzeichnen in der empirischen Sozialforschung die wissenschaftliche „Abbildung“ von Empirie in einer Theorie?

3. Was versteht man unter Konstrukten und unter Operationalisierungen?

4. Erklären Sie die Funktion von Stichproben in der Forschung und das Problem ihrer Repräsentativität!

5. Welche wichtigen Variablentypen gibt es in den empirischen Sozialwissenschaften?

6. Schildern Sie verschiedene Arten von Kausalbeziehungen und die INUS-Analyse!

7. Weshalb können die meisten psychologischen Gesetze nur wahrscheinlichkeitstheoretisch beschrieben werden?

8. Welche Schlüsse können aus dem Skalenniveau von Variablen gezogen werden?

9. Welche Bedeutung haben statistische Kennwerte von Variablen und Standardvariablen?

10. Wie lassen sich Variablen räumlich darstellen?

11. Erklären Sie die Korrelation als statistisches Zusammenhangsmaß und ihre Nutzanwendungen!

12. Worauf zielen inferenzstatistische Verfahren ab?

13. Erläutern Sie wichtige Forschungsmethoden der Psychologie!

14. Was versteht man unter Randomisierung?

15. Welche drei Hauptgütekriterien sollten allgemein in Datenerhebungsverfahren der Psychologie beachtet werden?

16. Was ist ein psychologischer Test und welchen Anforderungen sollte er genügen?

17. Welche wissenschaftlichen Ziele werden in der Psychologie mit Computersimulationen verfolgt?

18. Welche wichtigen Stadien weist der empiriewissenschaftliche Forschungsablauf auf?

Literatur

Bischof, N. (2014). Psychologie – Ein Grundkurs für Anspruchsvolle. Stuttgart.

Bischof, N. (2016). Struktur und Bedeutung. Göttingen

Bortz, J. & Döring, N. (2016). Forschungsmethoden und Evaluation für Human- und Sozialwissenschaftler. Berlin

Bühner, M. (2011). Einführung in die Test- und Fragebogenkonstruktion. München

Erdfelder, E., Mausfeld, R., Meiser, T. & Rudinger, G. (1996). Handbuch Quantitative Methoden. Weinheim

Flick, U., Kardorff, E., Keupp, H., Rosenstiel, L. & Wolff, S. (Ed.) (1995). Handbuch qualitative Sozialforschung. Grundlagen, Konzepte, Methoden und Anwendungen. München

Holling, H. & Schmitz, B. (Hrsg.) (2010). Handbuch Statistik, Methoden und Evaluation. Göttingen.

Kubinger, K. D. & Jäger, R. S. (Ed.) (2003). Schlüsselbegriffe der Psychologischen Diagnostik. Weinheim

Lamnek, S. (1995). Qualitative Sozialforschung. Bd. 1: Methodologie. Weinheim Maderthaner, R. (in Vorbereitung). Relationsanalyse (RELAN) – Systematik und Programm zur logischen und statistischen Analyse von Hypothesen und Daten in statistisch-empirischen Wissenschaften.

Rost, D. H. (2005). Interpretation und Bewertung pädagogisch-psychologischer Studien. Weinheim

Schnell, R., Hill, P.B. & Esser, E. (2005). Methoden der empirischen Sozialforschung. München

Steyer, R. (2003). Wahrscheinlichkeit und Regression. Berlin

Westermann, R. (2000). Wissenschaftstheorie und Experimentalmethodik. Göttingen

Конец ознакомительного фрагмента.

Текст предоставлен ООО «ЛитРес».

Прочитайте эту книгу целиком, купив полную легальную версию на ЛитРес.

Безопасно оплатить книгу можно банковской картой Visa, MasterCard, Maestro, со счета мобильного телефона, с платежного терминала, в салоне МТС или Связной, через PayPal, WebMoney, Яндекс.Деньги, QIWI Кошелек, бонусными картами или другим удобным Вам способом.