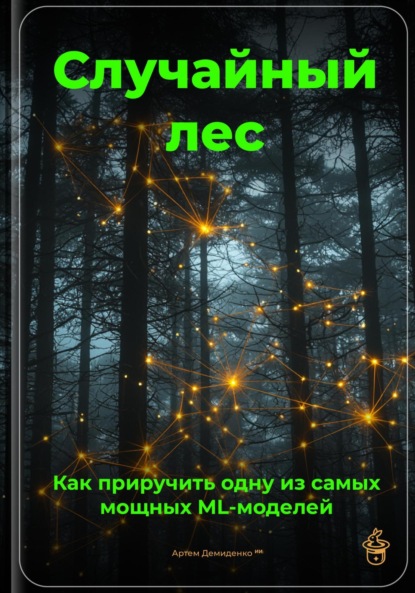

Случайный лес: Как приручить одну из самых мощных ML-моделей

- -

- 100%

- +

Введение в случайные леса и их применение в

ML

Случайные леса, как модель машинного обучения, являются мощным инструментом для решения самых различных задач, включая классификацию, регрессию и обработку данных. Но прежде чем углубляться в детали, стоит разобраться, что из себя представляют случайные леса, как они функционируют и в каких ситуациях могут быть наиболее полезны.

Суть случайного леса заключается в комбинации множества решающих деревьев, которые создаются с помощью метода обучения на выборках данных, известного как бутстрэппинг. Каждое дерево в лесу обучается на случайной подвыборке исходного набора данных, а также использует случайный набор признаков для принятия решений на каждом узле. Этот подход позволяет избежать переобучения и улучшить предсказательную способность модели за счет уменьшения вариации в предсказаниях.

Одно из значительных преимуществ случайных лесов – их универсальность. Они могут использоваться как для задач классификации, так и для регрессионных задач. Например, в задаче классификации вы можете предсказывать, будет ли клиент банка выполнять кредитные обязательства, анализируя такие признаки, как доход, кредитная история и возраст. В регрессионной задаче случайный лес может помочь предсказать, например, стоимость жилья на основе таких факторов, как площадь, количество спален и местоположение. Применяя случайные леса в этих примерах, важно использовать правильную метрику для оценки эффективности модели. Для классификации применяют точность, полноту и F1-меру, тогда как в регрессии используются RMSE (корень из среднеквадратичной ошибки) или R² (коэффициент детерминации).

Эффективное применение случайных лесов также включает в себя правильное управление гиперпараметрами, такими как количество деревьев в лесу и максимальная глубина каждого дерева. Обычная практика заключается в выполнении кросс-валидации с использованием сеточного поиска или случайного поиска для нахождения оптимальных значений этих параметров. К примеру, вы можете задать диапазоны для количества деревьев от 50 до 500 и максимальной глубины от 5 до 20, что позволит найти наиболее подходящие значения для конкретной задачи.

Следующий важный аспект – обработка недостатков данных и проблема несбалансированных классов. Случайные леса хорошо справляются с пропущенными значениями, так как деревья могут игнорировать несуществующие данные при обучении. Однако если ваши данные сильно несбалансированы, стоит рассмотреть техники ресемплинга, такие как увеличение более редкого класса или применение методов типа SMOTE (Техника синтетического увеличения меньшинства). Это значительно повысит качество прогноза, особенно в задачах бинарной классификации.

В дополнение к вышеуказанным практикам стоит отметить, что случайные леса обладают способностью проводить оценку важности признаков. Это дает вам возможность понять, какие факторы оказывают наибольшее влияние на вашу целевую переменную. Многие библиотеки для Python, такие как scikit-learn, предоставляют функции для автоматического вычисления важности признаков, что может помочь при отборе значимых характеристик и улучшении интерпретируемости модели.

Наконец, стоит упомянуть о недостатках случайных лесов. Они могут быть менее эффективными по сравнению с другими более современными моделями, такими как градиентный бустинг деревьев, особенно в ситуациях, когда данные имеют сложные, нелинейные взаимосвязи. Поэтому перед выбором метода стоит провести сравнительный анализ и тестирование, чтобы убедиться, что случайный лес действительно подходит для вашей задачи.

Суммируя, случайные леса представляют собой мощный и гибкий инструмент в арсенале специалиста по машинному обучению, подходящий для разнообразных задач и ситуаций. Их способность обрабатывать большие объемы данных, справляться с отсутствующими значениями и предоставлять интерпретируемые результаты делает их популярным выбором многих аналитиков. В следующих главах мы углубимся в детали реализации, оптимизации и практического применения случайных лесов, включая практические примеры кода и советы по устранению проблем, с которыми можно столкнуться в процессе работы.

Основные концепции и суть случайного леса

Случайные леса представляют собой ансамблевую модель машинного обучения, объединяющую в себе несколько простых предсказательных моделей, в основном решающих деревьев. Основная идея заключается в том, что группа слабых предсказателей может формировать мощный предсказатель, если они действуют совместно. В этой главе мы погрузимся в ключевые концепции, касающиеся построения и работы случайного леса.

Структура случайного леса

Случайный лес формируется из множества решающих деревьев, которые генерируются на основе случайных подмножеств данных. Каждое дерево обучается на случайно выбранной выборке, полученной методом бутстрэпинга – это процесс, при котором исходная выборка используется для создания новых выборок путём случайного выбора с возвращением. За счёт модификации выборок деревья не зависят друг от друга, что делает модель более устойчивой к переобучению.

Для более глубокого понимания можно рассмотреть простой пример: пусть у нас есть набор данных, содержащий характеристики клиентов банка (возраст, доход, семейный статус и т.д.) и целевой признак – остался ли клиент с банком. При обучении каждого дерева мы случайно выбираем, скажем, 70% клиентов из исходного набора. Это позволяет каждому дереву "увидеть" разные данные, что в конечном итоге приводит к созданию моделей, которые имеют различные мнения о том, останется ли клиент с банком.

Принцип голосования и предсказание

Когда речь заходит о получении финального предсказания случайного леса, используется метод голосования для классификации и усреднение для регрессии. Например, если случайный лес используется для классификации, каждая из моделей (деревьев) выдает свой класс, и финальный результат определяется большинством голосов.

Рассмотрим более наглядно: предположим, у нас есть три дерева, каждое из которых выдает следующие ответы на вопрос о том, останется ли клиент с банком: "Да", "Нет", "Да". В данном случае второй класс (нет) набирает одно голосование, а первый (да) – два. Значит, финальное решение, что клиент останется, будет принято.

Для регрессионной задачи, например, предсказания уровня дохода, среднее значение предсказаний всех деревьев будет использоваться для определения финального результата. Это позволяет сгладить ошибки отдельных деревьев и увеличить надежность модели.

Случайная выборка признаков

Параллельно с выборкой данных в случайных лесах также осуществляется случайная выборка признаков. Это означает, что для каждого разделения в дереве на каждом этапе обучения выбирается случайное подмножество признаков. Например, если у вас есть 10 признаков, то для каждого дерева может использоваться, скажем, 3 из них. Это увеличивает разнообразие деревьев и делает их более независимыми друг от друга.

Такая практика называется "разделение по случайным признакам" и в значительной степени способствует повышению эффективности модели, так как она менее уязвима к различным шумам в данных.

Параметры модели и их настройка

Существует несколько ключевых параметров, которые можно настраивать для оптимизации производительности модели случайного леса. Одним из основных является количество деревьев в лесу, заданное параметром `n_estimators`. Увеличение числа деревьев может привести к более точным предсказаниям, но также увеличивает время вычислений.

Другим важным параметром является `max_depth`, отвечающий за максимальную глубину каждого дерева. Установка этого параметра помогает избежать переобучения и уменьшает сложность моделей. Рекомендуется протестировать разные значения, чтобы определить оптимальную глубину, основанную на кросс-валидации.

Оценка качества модели

Эффективность случайного леса можно оценивать с помощью различных метрик, таких как точность, полнота, F1-мера и площадь под кривой ROC. Для регрессионных задач можно использовать среднеквадратичную ошибку и коэффициент детерминации. Использование кросс-валидации позволяет более точно оценивать качество модели, учитывая её работу на различных поднаборах данных.

Заключение

Случайный лес – это мощный инструмент в арсенале специалистов по машинному обучению, сочетающий простоту использования и высокую точность предсказания. Понимание основ этой модели, таких как структура случайного леса, голосование, случайная выборка признаков и настройка параметров, поможет вам применять её эффективно в разнообразных задачах. Воспользуйтесь приведенными методами и рекомендациями, чтобы лучше освоить данную модель и реализовать её в своих проектах.

Как работает метод ансамблей в машинном обучении

Ансамблевый метод – это подход в машинном обучении, который объединяет несколько моделей для улучшения общей производительности предсказаний. Такие методы становятся особенно актуальными, когда отдельные модели показывают недостаточную точность или надежность. В этой главе мы рассмотрим основные принципы работы ансамблей, их типы, преимущества и примеры применения.

Основные принципы ансамблевого метода

Суть ансамблевого метода заключается в том, чтобы объединить предсказания нескольких моделей в одно итоговое решение. Это достигается за счет того, что каждая модель может делать ошибки по-разному, и, комбинируя их результаты, мы можем снизить общий уровень ошибок. Существует два основных подхода к созданию ансамблей – это пакетный метод и метод усиления.

Пакетный метод включает случайный отбор подмножеств обучающих данных и обучение отдельных моделей на этих подмножествах данных. Случайные леса являются ярким примером этого подхода. Здесь каждое решающее дерево обучается независимо, и итоговый результат получается путем усреднения предсказаний или голосования.

Пример кода для реализации пакетного метода с использованием Python и библиотеки scikit-learn может выглядеть следующим образом:

python

from sklearn.ensemble import BaggingClassifier

from sklearn.tree import DecisionTreeClassifier

# Создаем базовую модель

base_model = DecisionTreeClassifier()

# Создаем модель пакетного метода

bagging_model = BaggingClassifier(base_estimator=base_model, n_estimators=100)

Метод усиления, с другой стороны, обучает модели последовательно, при этом каждая следующая модель акцентирует внимание на ошибках предыдущих. Это позволяет улучшать производительность ансамбля, минимизируя ошибки. Ярким примером метода усиления является алгоритм AdaBoost, который комбинирует слабые модели, придавая больший вес неправильно классифицированным объектам.

Пример кода для реализации AdaBoost может выглядеть следующим образом:

ython

from sklearn.ensemble import AdaBoostClassifier

from sklearn.tree import DecisionTreeClassifier

# Создаем базовую модель

base_model = DecisionTreeClassifier(max_depth=1)

# Создаем модель метода усиления

boosting_model = AdaBoostClassifier(base_estimator=base_model, n_estimators=50)

Преимущества использования ансамблевых методов

Использование ансамблей дает множество преимуществ. Во-первых, они обеспечивают более высокую точность предсказаний. Например, в задаче классификации отдельное решающее дерево может иметь высокую степень переобучения, но комбинирование нескольких деревьев может значительно повысить обобщающую способность модели.

Во-вторых, ансамбли устойчивы к выбросам и шумам в данных. Наличие нескольких моделей позволяет "сгладить" аномалии, которые могут привести к неправильным выводам, если полагаться только на одну модель. Это особенно полезно в случаях, когда данные имеют значительные отклонения или неполные записи.

В-третьих, ансамблевый подход обеспечивает более надежные и понятные результаты. Даже если одна из моделей плохо предсказывает, другие могут компенсировать этот недостаток, что приводит к более устойчивому итоговому предсказанию.

Примеры применения ансамблей

Ансамблевые методы находят широкое применение в различных областях. Например, в финансах их используют для определения кредитоспособности заемщиков, сочетая множественные модели для повышения точности прогнозов. В здравоохранении ансамбли помогают диагностировать заболевания на основе множественных показателей пациента, что значительно повышает вероятность правильного заключения.

В области компьютерного зрения ансамбли применяются для улучшения точности детекции объектов. Комбинируя предсказания различных моделей, таких как сверточные нейронные сети, можно добиться значительно лучших результатов в задачах классификации изображений.

Заключение

Ансамблевые методы в машинном обучении представляют собой мощный инструмент, который значительно повышает эффективность и точность предсказаний. Разобравшись в основных принципах работы, таких как пакетный метод и метод усиления, а также в их преимуществах, вы сможете применять ансамбли в своих проектах. Следующим важным шагом будет освоение таких методов, как случайные леса, которые уже включают в себя элементы ансамблевого подхода. С течением времени и практикой вы сможете использовать эти знания для решения самых сложных задач в области машинного обучения.

Деревья принятия решений как основа случайного леса

Сердцем случайного леса являются решающие деревья, и понимание принципов их работы критически важно для освоения этой мощной модели. Деревья принятия решений выступают в роли базовых предсказательных моделей в ансамбле и обеспечивают механизм, с помощью которого случайный лес может обрабатывать разнообразные типы данных и решать сложные задачи. В этой главе мы подробно рассмотриваем структуру и алгоритмы работы решающих деревьев, а также их сильные и слабые стороны.

Структура решающего дерева

Решающее дерево представляет собой графическую структуру, в которой внутренние узлы соответствуют признакам, а ветви – результатам тестов на этих признаках. Листовые узлы содержат классы (для задачи классификации) или значения (для регрессии). Каждое дерево начинается с корневого узла, представляющего набор всех данных. На каждом шаге данные разделяются по одному из признаков в зависимости от того, какой признак обеспечивает наилучшее разделение. Процесс продолжается до достижения заданной глубины дерева или до того момента, когда в узле остаётся недостаточно данных для дальнейшего разделения.

Использование определённых методов выбора признаков и критериев разбиения, таких как индекс Джини или среднеквадратичная ошибка, позволяет находить наиболее информативные разбиения. Например, для классификации можно использовать индекс Джини для измерения чистоты узла: чем ниже значение, тем более однородным будет узел после разбиения.

Алгоритм построения решающего дерева

Алгоритм CART (дерева классификации и регрессии) является одним из самых распространённых для построения решающих деревьев. Он работает следующим образом:

1. Получение всех возможных разбиений: Для каждого признака создаётся множество разбиений, определяющих, к какой категории будут относиться данные.

2. Расчёт критерия качества: Для каждого разбиения вычисляется значение критерия (например, индекс Джини).

3. Выбор наилучшего разбиения: Выбирается разбиение с наилучшим значением критерия, которое минимизирует разброс значений в дочерних узлах.

4. Повторение: Процесс повторяется для каждой дочерней ветви, пока не будет достигнуто заданное условие остановки (например, минимальное количество примеров в узле).

Пример кода на Python для построения простого решающего дерева с использованием библиотеки `scikit-learn` может выглядеть следующим образом:

```

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import train_test_split

# Загрузка данных

iris = load_iris()

X_train, X_test, y_train, y_test = train_test_split(iris.data, iris.target, test_size=0.3)

# Создание и обучение дерева

tree = DecisionTreeClassifier(max_depth=3)

tree.fit(X_train, y_train)

# Оценка точности

accuracy = tree.score(X_test, y_test)

print(f"Точность модели: {accuracy:.2f}")

```

Сильные стороны решающих деревьев

Решающие деревья обладают рядом преимуществ, делающих их привлекательными для использования в качестве базовых моделей в случайном лесу:

– Прозрачность и интерпретируемость: Структура дерева позволяет легко понять, как модель принимает решения и какие признаки являются наиболее значимыми.

– Гибкость: Деревья могут обрабатывать как числовые, так и категориальные данные, что делает их универсальными для различных задач.

– Не требуют масштабирования данных: Деревья могут эффективно работать с неотмасштабированными данными.

Слабые стороны решающих деревьев

Несмотря на свои достоинства, решающие деревья имеют и недостатки, особенно в контексте их одиночного использования:

– Переобучение: Деревья часто склонны к переобучению, особенно при глубоком разбиении, что приводит к плохой обобщающей способности.

– Чувствительность к шуму: Небольшие изменения в обучающих данных могут привести к значительным изменениям в структуре дерева.

– Предвзятость к данным: Деревья могут показывать предвзятость к определённым признакам, особенно если они имеют более высокий порядок значимости.

Устранение недостатков решающих деревьев

Чтобы минимизировать эти недостатки, можно применять различные методы. Одним из самых эффективных является обрезка. Этот процесс включает в себя удаление узлов, которые не улучшают качество предсказаний. Это помогает уменьшить глубину дерева и, следовательно, снизить риски переобучения.

Также стоит обратить внимание на использование кросс-валидации при выборе гиперпараметров модели, таких как максимальная глубина дерева и минимальное количество образцов в листьях. Практически применяя кросс-валидацию, можно лучше оценить истинную производительность модели.

Заключение

Решающее дерево – мощный инструмент для анализа и предсказания, однако для достижения наилучших результатов имеет смысл использовать их в ансамбле, таком как случайный лес. Понимание основ работы решающих деревьев, их сильных и слабых сторон позволит вам не только эффективно создавать модели, но и добиваться более высокой степени точности и устойчивости в ваших предсказаниях. С переходом к случайным лесам вы сможете использовать преимущества множества деревьев и устранить недостатки одиночных моделей, что приведёт к значительно более высоким результатам.

Процессы построения деревьев для случайного леса

Построение деревьев является основополагающим процессом в формировании случайного леса. На этом этапе создаются различные решающие деревья, которые впоследствии станут частью ансамбля. Каждый этап требует внимательного подхода к выбору данных и параметров, что непосредственно влияет на качество предсказаний модели.

Выбор и подготовка данных

Для начала важно понимать, что случайный лес использует метод бутстрэппинга для создания подвыборок из исходного набора данных. Этот метод заключается в случайном выборе объектов с возвращением, что позволяет создать несколько уникальных подмножеств. Таким образом, каждое дерево будет обучаться на своем собственном наборе данных, что позволяет значительно уменьшить вероятность переобучения.

Для примера, пусть у нас есть датафрейм с 1000 записями. Мы можем создать, скажем, 100 деревьев. Для каждого из этих деревьев будет случайным образом выбрано, скажем, 700 записей. Применяя бутстрэппинг, мы можем заметить, что некоторые записи будут включены в выборку несколько раз, в то время как другие могут и вовсе отсутствовать.

Определение признаков и их случайный отбор

Еще один важный аспект в процессе построения деревьев – выбор признаков. Случайный лес использует метод случайного выбора подмножества признаков на каждом шаге расщепления дерева. Этот подход является ключевым для обеспечения разнообразия деревьев в ансамбле.

Рассмотрим это на примере данных о клиентской базе, где у нас есть 10 признаков (например, возраст, доход, статус семьи и т.д.). Вместо использования всех 10 признаков при каждой итерации, мы можем случайно выбрать, например, 3 из них. Это случайное ограничение делает каждое дерево уникальным и снижает взаимосвязь между деревьями.

Построение дерева

В процессе построения дерева для каждой подвыборки данных и выбранного подмножества признаков осуществляется разбиение на узлы. На каждом узле выбирается атрибут, который обеспечивает наилучшее разделение данных по критерию уменьшения неоднородности, например, при помощи индекса Джини или энтропии.

Чтобы реализовать этот процесс в коде, мы можем воспользоваться популярной библиотекой scikit-learn в Python. Пример создания дерева может выглядеть следующим образом:

```python

from sklearn.tree import DecisionTreeClassifier

from sklearn.datasets import load_iris

iris = load_iris()

clf = DecisionTreeClassifier(criterion='gini', max_depth=3)

clf.fit(iris.data, iris.target)

```

Таким образом, мы создаем классификатор, который обучается на данных и использует индекс Джини для разбиения на узлы.

Условия остановки

Построение дерева продолжается до тех пор, пока не будут выполнены условия остановки. Эти условия могут включать достигаемую максимальную глубину дерева, минимальное количество образцов, необходимое для расщепления узла, или минимальное число образцов в листовом узле. Правильная настройка этих параметров критически важна для предотвращения переобучения – если модель слишком сложная, то она не сможет обобщать на новых данных.

Укрепление модели

Каждое дерево в случайном лесу должно быть достаточно сильным, чтобы сделать предсказание, но при этом не слишком сложным, чтобы не терять в обобщающей способности. Поэтому практическим советом будет настройка параметров на кросс-валидационных выборках, чтобы добиться наилучшей производительности.

Например, если мы обнаружим, что деревья с глубиной более 5 начинают показывать ухудшение на валидационных данных, стоит рассмотреть возможность снижения максимальной глубины, чтобы улучшить обобщающие способности нашего ансамбля.

Итоговый анализ и оценка

Наконец, после того как все деревья построены, каждый из них вносит свой вклад в общее предсказание через метод голосования (для классификации) или усреднения (для регрессии). Это позволяет не только повысить точность предсказаний, но и снизить дисперсию модели, поскольку ошибка отдельных деревьев часто компенсируется другими.

В процессе итогового анализа полезно провести визуализацию каждого дерева и рассмотреть их структуру на предмет важности признаков. Это позволит не только понять, какие факторы влияют на предсказания, но и выявить возможные аномалии в данных.

Таким образом, процесс построения деревьев в случайном лесу – это многоступенчатый и проницательный подход, включающий выбор данных, случайный отбор признаков, создание деревьев и их взаимодействие. Применяя эти методы на практике, вы сможете полноценно использовать мощные возможности случайного леса и получать качественные предсказания.

Случайность в отборе признаков и подвыборок данных

Метод случайных лесов отличается от многих других моделей машинного обучения благодаря своей стратегии выбора подвыборок данных и признаков. Сочетание случайности в этих процессах не только улучшает производительность модели, но и обеспечивает её устойчивость и надежность. Изучив принципы случайного выбора, вы сможете гораздо эффективнее использовать случайный лес для решения своих задач.